Übersicht

In diesem Artikel geht es um das Upscaling von Bildern in ComfyUI, mit Fokus auf KI-basierte Upscaling-Modelle wie SUPIR. Du lernst, wie Upscaling grundsätzlich funktioniert, wann traditionelle oder KI-gestützte Methoden sinnvoll sind und welche KI-Modelle dir zur Verfügung stehen.

Alle vorgestellten Techniken, Modell-Links sowie meinen persönlichen Upscaling-Workflow findest du hier kompakt zusammengestellt. Den Workflow kannst du direkt herunterladen, um ihn sofort in deinen eigenen Projekten einzusetzen.

Ich selbst habe Monate lang mit dem falschen Upscaler gearbeitet und musste die Fehler später mühsam ausbügeln – nur weil ich mir nicht die Zeit genommen habe, mir eine Übersicht zu verschaffen und einfach den erstbesten gewählt habe. Wenn du verstehst, wie Upscaling in ComfyUI funktioniert, kannst du das passende Modell zur richtigen Zeit einsetzen – das sorgt für bessere Bildqualität und einen reibungsloseren Workflow. Ein Beispiel dafür ist SUPIR, ein Bildrestaurierungs-Modell, das die Bildqualität verbessert, ohne die Auflösung zu erhöhen. Mehr dazu gibt es in Kapitel 3.

1 Grundlagen

Egal, ob du am Ende deines Workflows das Bild vergrößerst, um mehr als die typische SDXL- oder Flux-Auflösung zu bekommen, oder du einen kleinen Bereich des Bildes vergrößern willst, um ihn anschließend weiter zu bearbeiten – Upscaling findet in der Bildbearbeitung und ComfyUI oft Anwendung und gehört zu den grundlegenden Techniken, um gute Workflows zu bauen.

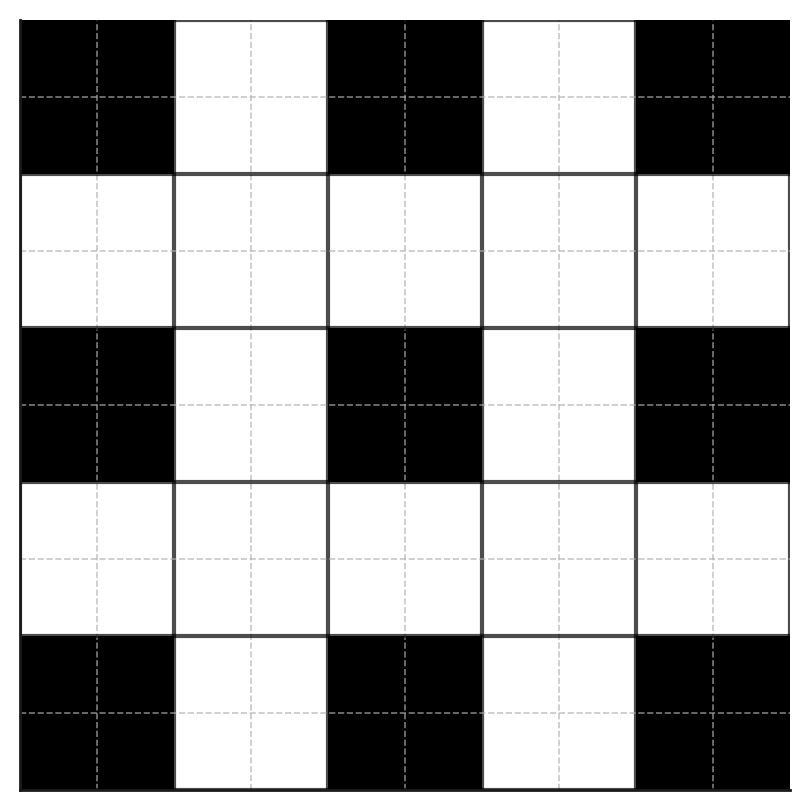

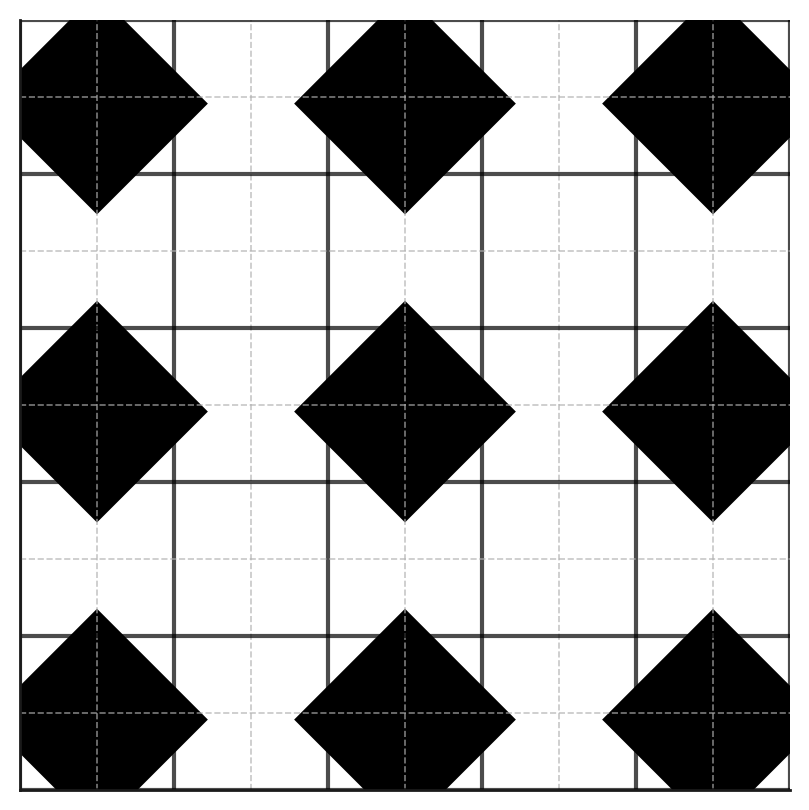

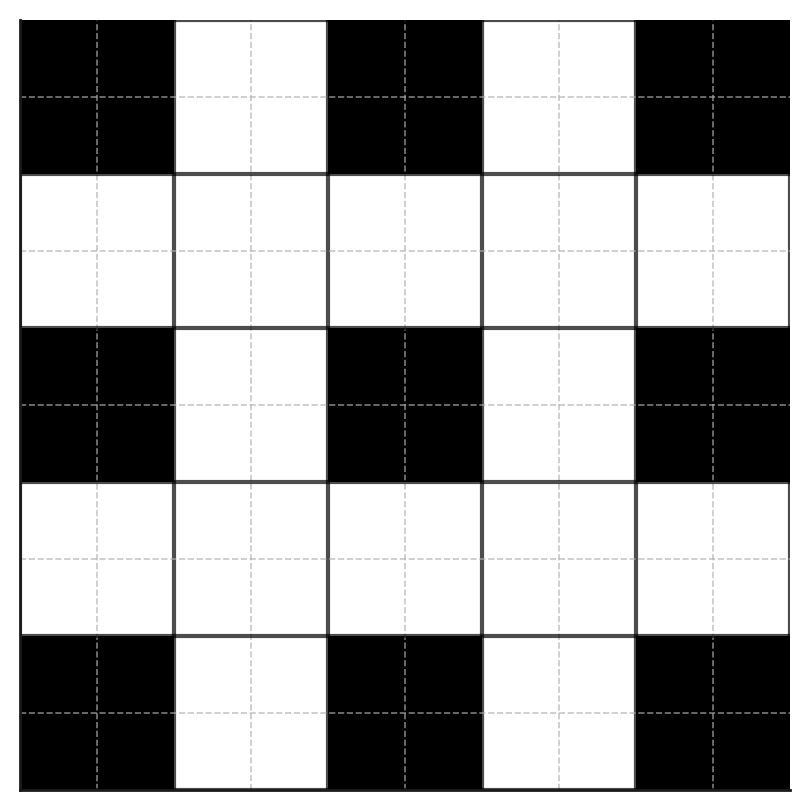

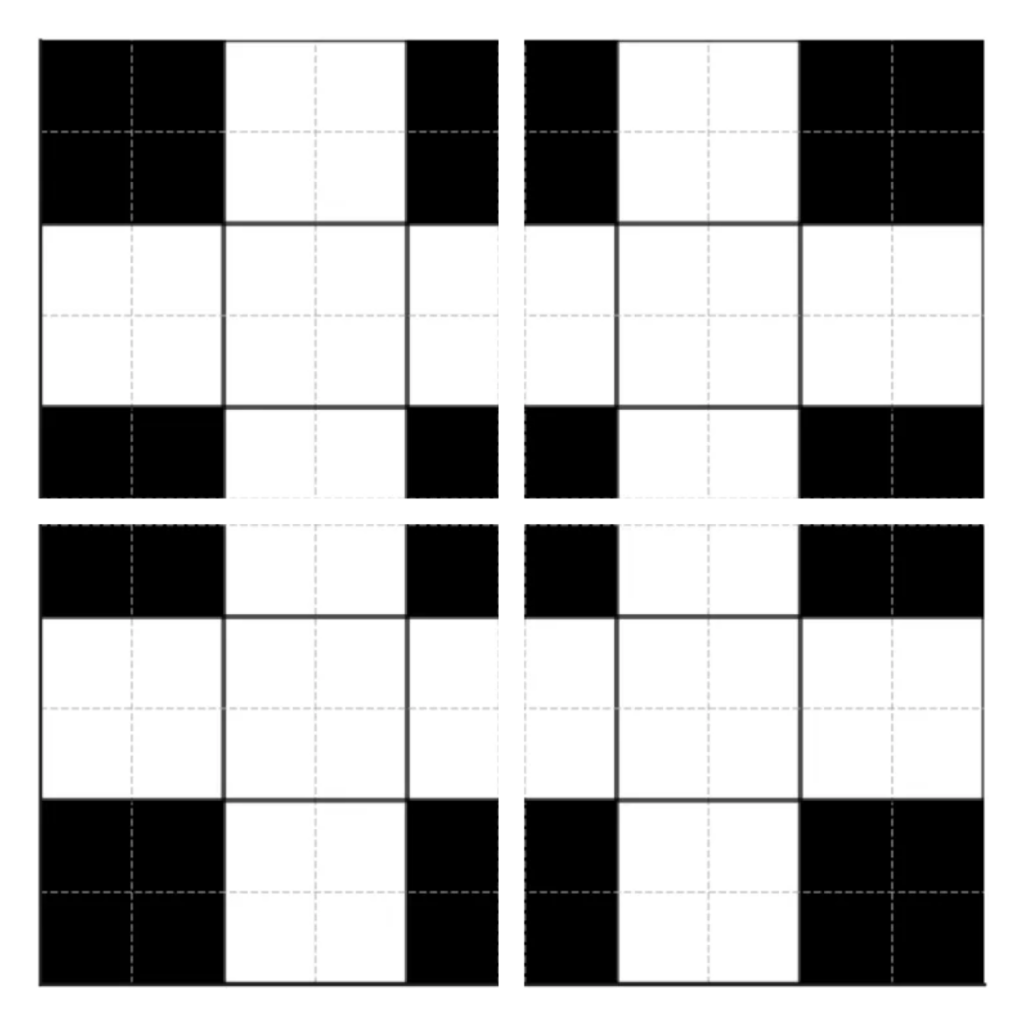

Grundsätzlich bedeutet Upscaling, dass die Auflösung eines Bildes erhöht wird, wodurch die Seitenlängen größer werden und mehr Pixel entstehen. Da diese neuen Pixel vorher nicht existiert haben, müssen ihre Farbwerte berechnet werden. Im Beispielbild „Upscale-Raster“ stehen die weißen Felder für undefinierte Pixel.

Am Anfang war mir nicht bewusst, dass Upscaler nicht nur zur Vergrößerung von Bildern verwendet werden, sondern auch bei Rotationen. Ich wusste nicht, dass beim Rotieren eines Bildes die Pixel neu angeordnet werden.

Der Grund ist, dass das Bild aus einem Raster fester Pixel besteht und dieses Raster in der Regel nicht exakt zu den neuen, gedrehten Positionen passt. Durch die Drehung entstehen Zwischenräume, die nicht direkt mit vorhandenen Pixeln gefüllt werden können.

Wenn Pixel fehlen, leere Zwischenräume entstehen oder Pixel verformt werden, können Upscaler genutzt werden, um fehlende Bildinformationen zu ergänzen und anzupassen. Dafür gibt es zwei grundlegende Methoden:

Traditionelles Upscaling (z. B. bilineare, bikubische oder Lanczos)

- Diese vergrößern die Bildabmessungen, fügen jedoch keine neuen Details hinzu.

KI-basiertes Upscaling

- Vergrößert und erzeugt zusätzliche Details, die ursprünglich nicht vorhanden waren.

Wichtig: KI-basierte Upscaler vergrößern nicht nur Bilder, sondern verbessern auch Details. Solche Modelle nennt man auch Bildrestaurierungs Modelle. Da moderne KI-Upscaler beides tun – skalieren und Details rekonstruieren – sind sie in der Regel Upscaler und Bildrestaurierungs-Modelle gleichzeitig. Allerdings sind nicht alle Bildrestaurierung-Modelle klassische Upscaler, da einige nur die Bildqualität verbessern, ohne die Auflösung zu erhöhen.

2 Einleitung KI-basierte Upscaler

Wie es bei SDXL verschiedene Modelle gibt, existieren auch bei KI-Upscalern unterschiedliche Ansätze, die jeweils auf bestimmte Aufgaben spezialisiert sind – beispielsweise zur Verbesserung von Gesichtern oder Landschaften. Außerdem beruhen Upscaler auf unterschiedlichen Architekturen, die jeweils ihre eigenen Vor- und Nachteile mitbringen. Deshalb ist Ausprobieren notwendig, um das richtige Modell zu finden, das zu deinen individuellen Anforderungen passt.

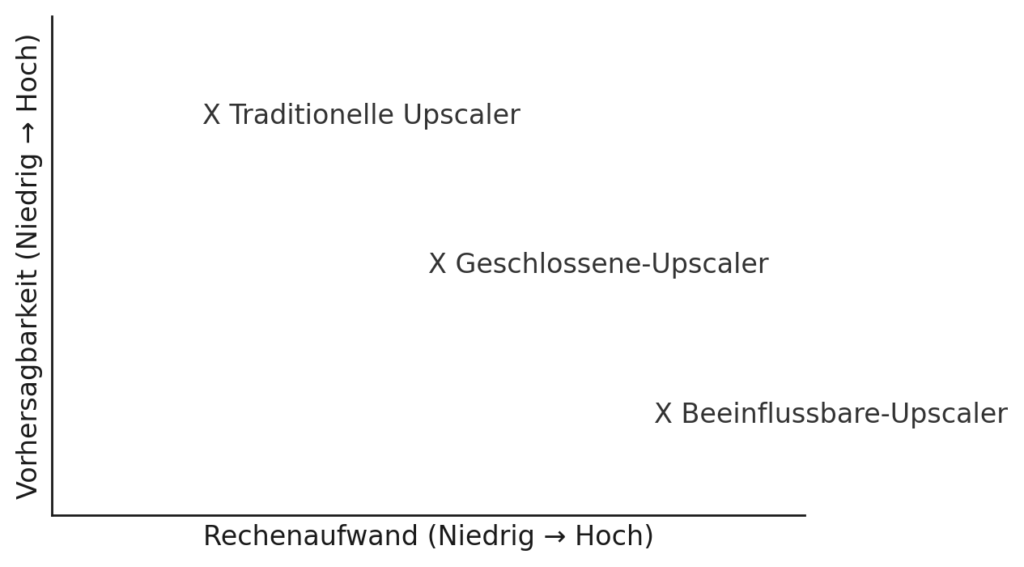

Ich unterteile Upscaler in zwei Kategorien:

Beeinflussbare Modelle:

Diese Modelle erlauben es, das finale Ergebnis durch externe Parameter wie Seed, Prompts oder andere einstellbare Werte zu steuern. Ein Beispiel dafür ist SUPIR, das in Kombination mit einem Diffusionsmodell arbeitet. Auch ein klassischer img2img-Upscale, bei dem ein Bild zunächst mit einem traditionellen Upscaler (wie Lanczos) vergrößert und anschließend im img2img-Prozess weiterverarbeitet wird, gehört zu dieser Gruppe. In Foren werden diese Modelle oft als diffusionsbasierte Modelle bezeichnet.

Geschlossene Modelle:

Diese Modelle liefern bei identischer Eingabe stets dasselbe Ergebnis, da sie auf fest definierten neuronalen Netzwerken basieren und man im Gegensatz zu den beeinflussbaren Modellen keine Parameter einstellen kann. Dadurch erhält man in der Regel stabilere Ergebnisse, wenn ein Modell verwendet wird, das speziell auf den jeweiligen Anwendungsfall trainiert wurde. Beispiele dafür sind Modelle wie 4xNomos2_otf_esrgan oder 4xNomos8kDAT. In Foren werden diese Modelle oft als deterministische Modelle bezeichnet.

Mit dieser Unterscheidung kannst du in deinen Workflows entscheiden, ob du den kreativen Spielraum eines beeinflussbaren Upscalers nutzen möchtest oder ob du auf die Stabilität geschlossener Modelle setzen willst.

Eine bekannte Seite für Upscale-Modelle ist OpenModelDB, dort findest du vorwiegend nicht beeinflussbare Modelle, die für unterschiedliche Anwendungsbereiche gemacht wurden und unter anderem Upscaling bis zu 16x ermöglichen.

3 SUPIR

SUPIR ist eine diffusionsbasierte Methode, die gezielt Details verbessert und zur Kategorie der Bildrestaurierung gehört. Es lässt sich mit einem ControlNet vergleichen, da es Einfluss auf bestimmte Bildbereiche nimmt und nicht pauschal das Bild vergrößert.

Als SUPIR zum ersten Mal erschien, war ich – da ich noch nicht viel Erfahrung mit Upscalern hatte – sehr beeindruckt und dachte, dass es, weil es eine neue Methode war, die beste Lösung sein müsste. Deshalb verwendete ich es nicht für klassische Bildrestaurierung, also zum Verbessern stark verpixelter Bilder, sondern um bereits gute Bilder nur noch etwas detailreicher wirken zu lassen. Doch wie bei vielen diffusionsbasierten Upscalern ist der Grat zwischen leichter Detailverbesserung und unerwünschten Veränderungen (Halluzinationen) schmal, sodass SUPIR bei vielen Bildern zu stark vom ursprünglichen Motiv abwich.

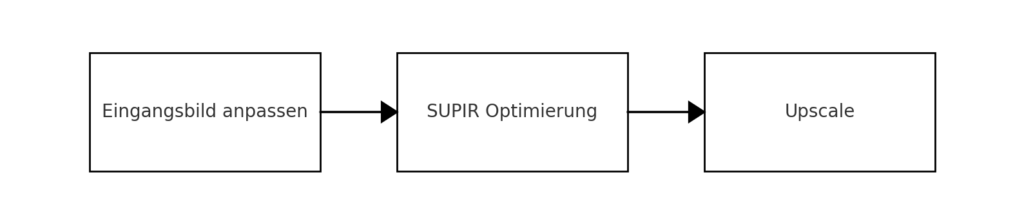

Mein SUPIR Workflow ist folgendermaßen gegliedert:

Eingangsbild

Bildanforderungen:

- Seitenlängen durch 32 teilbar, Größe nahe 1024×1024 Pixel

Mögliche Probleme:

- Abweichende Abmessungen von 1024×1024 Pixeln können zu Qualitätsverlust führen

Eigene Erfahrung:

- Auch bei Eingangsbildern über 4 MP waren die Ergebnisse zufriedenstellend

SUPIR ist ein leistungsfähiges Modell, aber nicht für jeden Bildtyp geeignet, da die Trainingsdaten nicht alle möglichen Szenarien abdecken. Besonders gut funktioniert es bei Landschaften und Porträts, während es bei spezialisierten oder ungewöhnlichen Motiven an seine Grenzen stoßen kann. Ein Beispiel dafür sind Bilder mit feinen, technischen Mustern oder regelmäßigen Rastern – hier kann es zu Verzerrungen oder unerwünschten Artefakten kommen.

Auch wenn SUPIR das richtige Modell für deine Anwendung ist, kannst du trotzdem schlechte Ergebnisse erhalten, falls du die Parameter nicht im Griff hast – diese Parameter stelle ich im folgenden Teil des Artikels vor. Im Upscale-Workflow findest du die Erklärungen zu jedem Parameter direkt bei den jeweiligen Nodes. Zudem gibt es eine vor eingestellte Parameterauswahl, die Details dezent ergänzt, ohne das Bild übermäßig zu verändern.

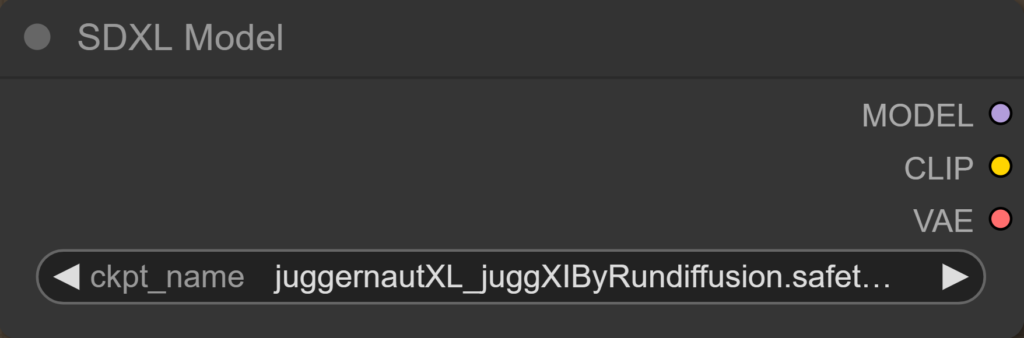

SDXL Model

Auf der SUPIR-GitHub-Seite wird Juggernaut-XL_v9 empfohlen, jedoch kannst du auch andere SDXL-Modelle als Basis verwenden. Besonders zu Beginn ist ein Lightning-Modell empfehlenswert, um ein Gefühl für die Parameter zu bekommen. Wichtig: Das gewählte Modell sollte zum Typ des Bildes passen, das vergrößert werden soll.

SDXL-Modell:

SUPIR-GitHub:

https://github.com/Fanghua-Yu/SUPIR

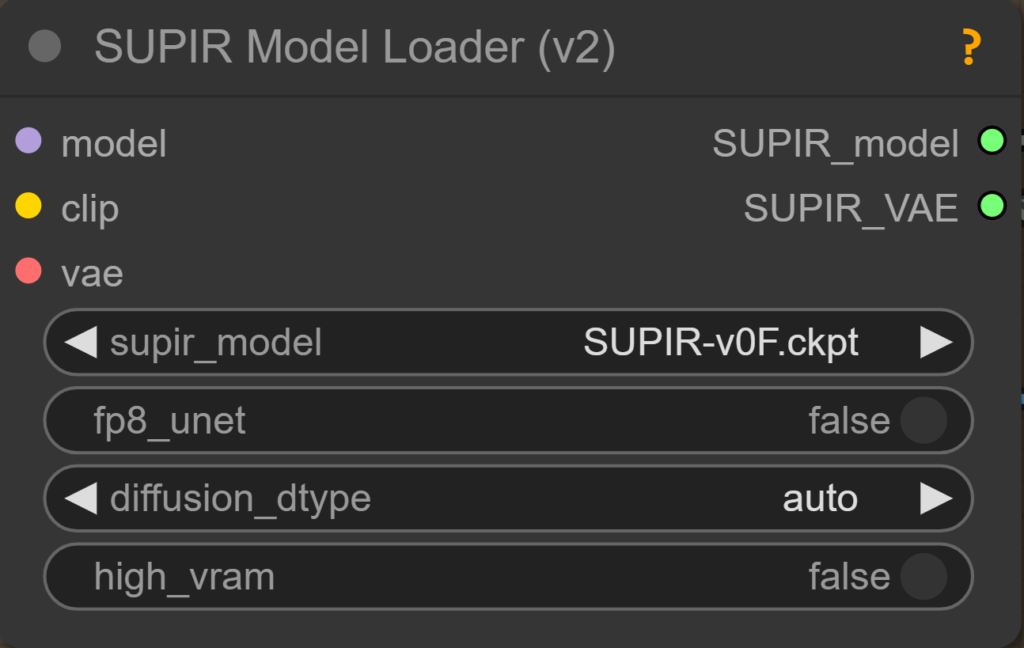

SUPIR Model Loader(v2)

Lädt das SUPIR-Modell und merged es mit dem SDXL-Modell.

supir_model:

- SUPIR-v0Q: Allgemeines Modell.

- SUPIR-v0F: Fine-tuned Modell; bei manchen Bildern sehr gute, bei anderen weniger gute Ergebnisse.

Full- und pruned Modelle:

fp8_Unet:

- Aktivieren, wenn VRAM-Probleme auftreten (wandelt Unet-Gewichte um, spart VRAM, leichte Qualitätsminderung).

diffusion_dtype:

- Legt die Berechnungsgenauigkeit fest:

- fp16: Empfohlen.

- bf16: Mittelding zwischen fp16 und fp32 soll ähnliche Qualität wie fp32 erzeugen aber trotzdem weniger Speicherintensiv sein

- fp32: Genauere Berechnungen, benötigt aber 24GB VRAM.

- Standardmäßig auf „auto“ gesetzt; nur bei Ladeproblemen anpassen.

high_vram:

- Aktivieren ab 24GB VRAM; nutzt Accelerate, um Gewichte direkt auf die GPU zu laden und beschleunigt den Ladeprozess.

- Accelerate ist ein Tool das den Einsatz von GPUs optimiert und das Laden sowie die Ausführung von Modellen effizienter gestaltet.

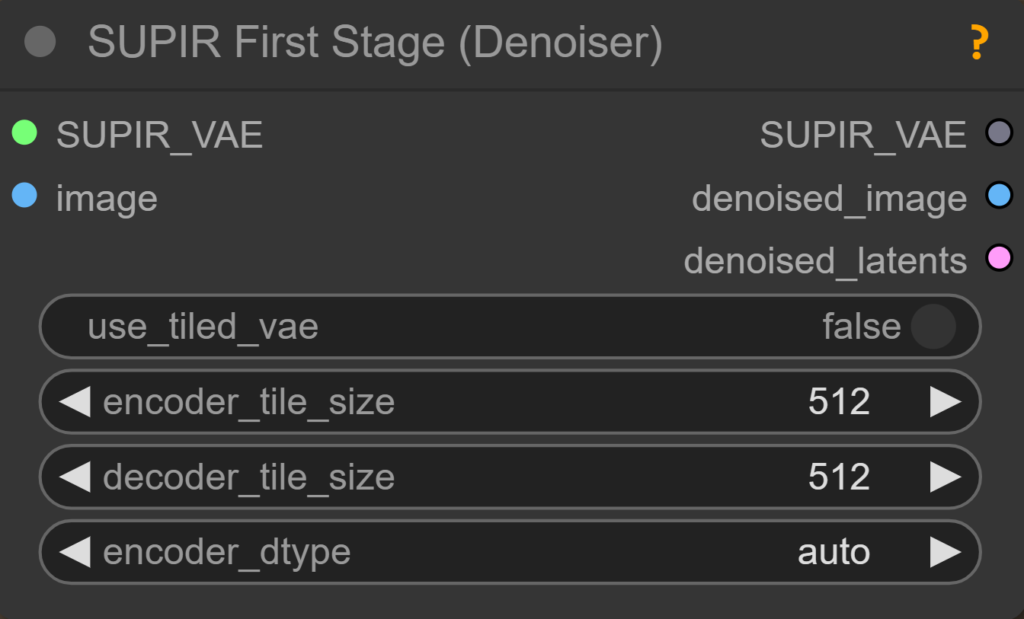

SUPIR First Stage (Denoiser)

Ziel des First Stage Denoiser ist es, Kompressionsartefakte zu beheben – was häufig zu einer Unschärfe im Endergebnis führt. Der Denoiser kann durch einen beliebigen anderen Denoiser/Blur ersetzt oder ganz weggelassen werden beim SUPIR Conditioner. Meine Erfahrung zeigt: Je stärker das Bild geblurt oder verwischt wird, desto verwischter wird der abschließende Upscale, und die Details erscheinen grober. Wenn es also nur um kleine Änderungen geht, lasse ich das denoised_latent beim SUPIR Conditioner weg und gebe nur das denoised_image an den SUPIR Encoder weiter.

Hinweis zum Tiled-Verfahren:

In meinen Tests wird die beste Bildqualität erreicht, wenn das gesamte Bild in einem Durchgang verarbeitet wird. Daher wird in diesem Schritt die Tile Size nicht aktiviert. Ob eine Aktivierung sinnvoll ist, hängt von der verfügbaren Rechenleistung und der Bildgröße ab. Falls du nicht verstehst was Tiling ist siehe Kapitel 6.

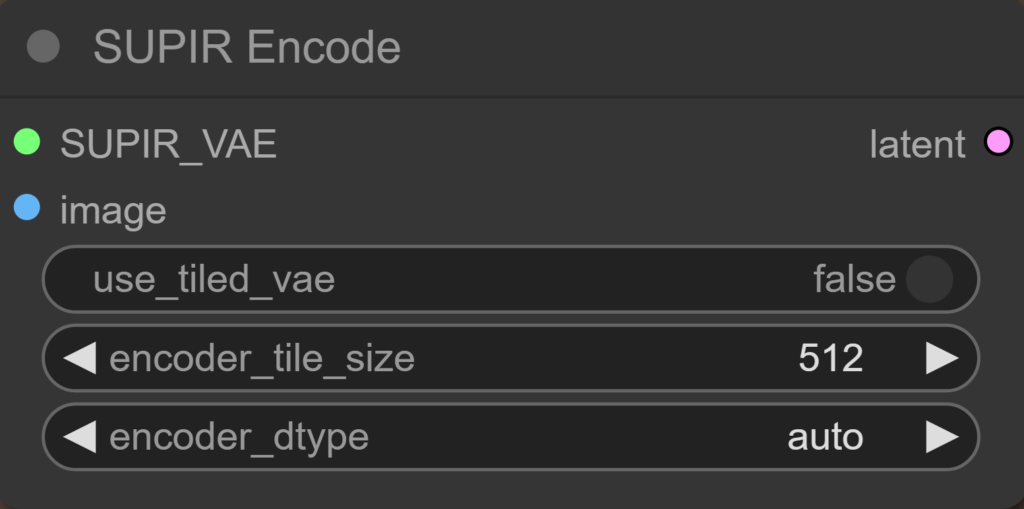

use_tiled_vae:

- Aktiviert das Aufteilen des Bildes in Tiles/Kacheln.

- Kann die Speichernutzung optimieren, besonders bei großen Bildern.

- Es sollte geprüft werden, ab wann der Nutzen der reduzierten Speichernutzung durch längere Verarbeitungszeiten aufgehoben wird.

encoder_tile_size:

- Legt die Kachelgröße fest, mit der der Encoder arbeitet.

- Eine kleinere Tile Size kann den Speicherbedarf reduzieren, führt aber zu einer längeren Verarbeitungsdauer.

decoder_tile_size:

- Legt die Kachelgröße für den Decoder fest.

- Eine Anpassung kann helfen, den VRAM-Bedarf zu verringern.

encoder_dtype:

- Bestimmt den Datentyp für die Berechnungen im Encoder.

- Eine Einstellung wie fp16 ermöglicht schnellere Berechnungen und reduziert den Speicherverbrauch, während fp32 eine höhere Genauigkeit bietet.

SUPIR Encode

Encodiert das Bild für den SUPIR Sampler. Dabei sollten die Einstellungen identisch zu denen des First Stage Denoisers gewählt werden, um ein konsistentes Ergebnis zu erzielen.

Hinweise:

- Entscheidend ist, ob im Conditioner das Latent aus dem First Stage Denoiser oder aus dem SUPIR Encoder verwendet wird – dies beeinflusst, ob die Details grober ausfallen oder nicht.

- Das Latent des SUPIR Encoders kann auch durch das Latent des SUPIR First Stage (Denoiser) ersetzt werden, wobei in meinen Tests kein Unterschied erkennbar war, wenn der SUPIR Conditioner das Latent des SUPIR First Stage (Denoiser) genutzt hat.

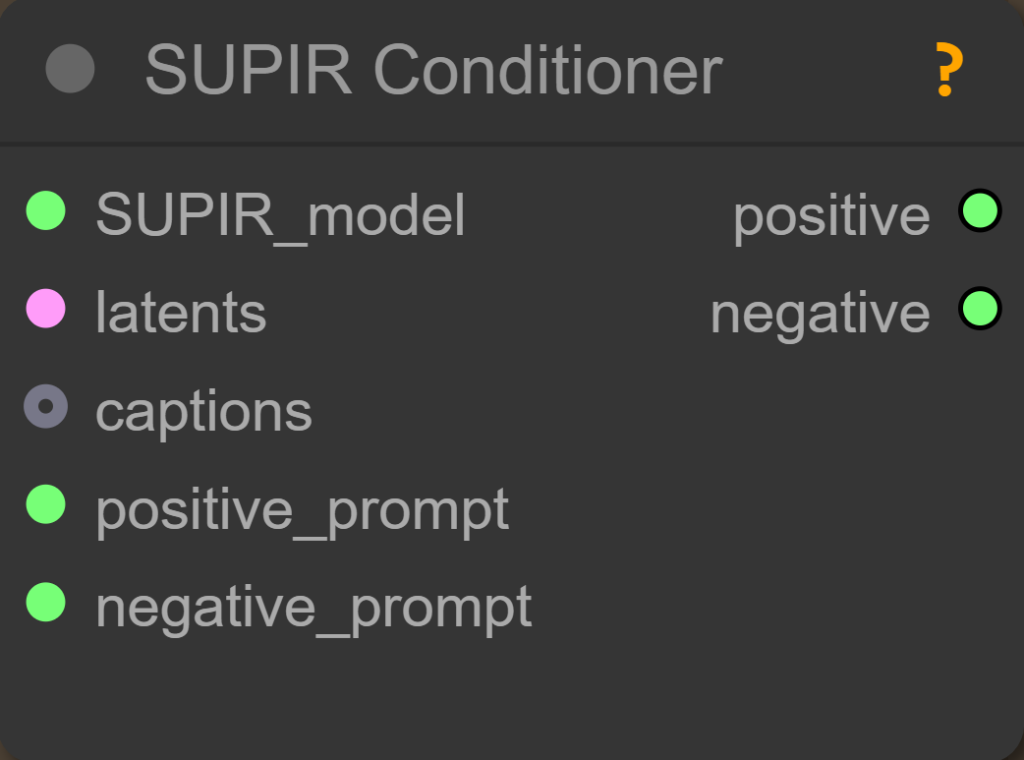

SUPIR Conditioner

SUPIR Conditioner erstellt das Conditioning für den Sampler und spielt dabei eine wesentliche Rolle bei dessen Steuerung. Entscheidend ist, welches Latent verwendet wird – entweder das aus dem SUPIR Encoder oder das aus dem SUPIR First Stage Denoiser –, da dies darüber entscheidet, wie grob die Details im Endergebnis erscheinen.

SUPIR_model:

- Das ausgewählte SUPIR-Modell (z. B. SUPIR-v0Q oder SUPIR-v0F).

latents:

- Das Latent, das vom Encoder oder vom First Stage Denoiser stammt.

captions:

- Ermöglichen das Zuweisen individueller Prompts pro Tile oder Bildbatch.

- Damit habe ich allerdings keine Erfahrung.

positive_prompt:

- Ein Standardprompt wie „high quality, detailed“ wird empfohlen, kann aber je nach Bild für bessere Ergebnisse angepasst werden.

negative_prompt:

- Standardmäßig wird „bad quality, blurry, messy“ empfohlen, um unerwünschte Bildaspekte zu entfernen. Je nach Bild können diese Angaben jedoch angepasst werden.

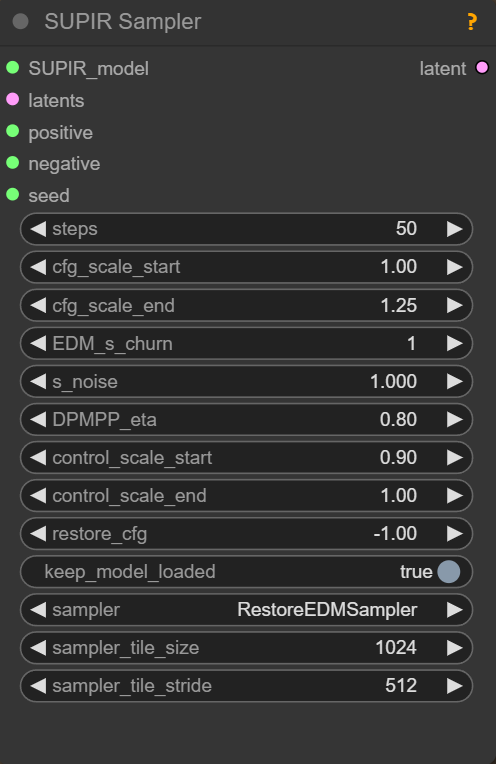

SUPIR Sampler

Der SUPIR Sampler ist der Kern des SUPIR-Upscalers. Ein gutes Verständnis der einzelnen Parameter ermöglicht es, das beste Ergebnis zu erzielen.

Steps:

- Wie beim Checkpoint empfohlen.

cfg start/end:

- Je höher, desto mehr Detail.

- Sind die Zahlen identisch, bleibt der CFG immer gleich.

EDM_s_churn(Error Diffusion Model):

- 1, wenn man wenig Änderung will.

- Eine Erhöhung über 1 bringt kaum Änderungen, wenn s_noise = 1.

- Funktioniert nur mit EDM Samplern.

s_noise:

- Sigma noise – je höher, desto mehr Veränderung.

- Gibt an, wie viel Noise beim EDM genutzt wird.

- Minimalwert ist 1, maximal 1.1.

DPMPP_eta:

- Eta-Wert – das Maß an Rauschen, das während des Denoising-Prozesses für den Noise Scheduler verwendet wird.

- Ein kleinerer Wert bedeutet weniger Zufälligkeit in der Generierung.

- Default ist 1. (Konnte keinen Effekt zwischen 0.2 und 4 feststellen)

Control_scale:

- Internes ControllNet.

- Je geringer der Wert, desto mehr ändert sich das Bild.

restore:

- Für Bilder mit sehr schlechter Qualität sollte ein Wert zwischen 1 und 20 eingestellt werden.

- Bei guten Bildern – die nur verbessert werden sollen – -1 (Deaktivierung).

- Funktioniert nur mit EDM Samplern.

keep_model_loaded:

- Lässt das Modell in der Node geladen, was Rechenleistung spart, wenn man das gleiche Bild mit einem anderen Seed ausprobieren möchte.

samplers:

- EDM Sampler benötigen viele Schritte, liefern aber generell eine höhere Qualität.

- DPMPP Sampler funktionieren gut mit weniger Schritten und sind daher für Lightning-Modelle geeignet.

- Tiled Sampler ermöglichen einen tiled Diffusionsprozess.

Sampler tile size:

- Gibt an, wie groß die Flächen sind, in die das Bild aufgeteilt wurde, und sollte identisch zur zuvor eingestellten Tile Size sein.

Sampler tile stride:

- Bestimmt, wie stark sich die tiled Flächen überlappen sollen

Um ein Gefühl für die Parameter zu bekommen empfehle ich dir meinen Upscale Workflow zu downloaden und beim ausprobieren die Erklärungen, die direkt bei den Nodes stehen, zu nutzen.

Am Ende des SUPIR Workflows wird ein einfacher Upscale mit Lanczos durchführt um die gewünschte Größe zu bekommen.

4 Geschlossene Upscaler

Spezialisierte KI-Upscale-Modelle werden gezielt für verschiedene Anwendungen trainiert. Sie sind zwar nicht so flexibel steuerbar wie SUPIR, aber ressourcenschonend, leicht in Workflows integrierbar, häufig kommerziell nutzbar und oft die beste Lösung für spezifische Probleme wie das Entfernen von JPEG- oder WebP-Artefakten.

Um schneller das richtige Modell zu finden, musst du die Suche gezielt eingrenzen. Das gelingt dir, wenn du die relevanten Fachbegriffe kennst, die beim Upscaling verwendet werden und weißt was du willst.

Thema: Welche Art von Bild soll hochskaliert werden?

Beispielsweise gibt es Modelle für Anime, Manga oder Pixel Art, die darauf optimiert sind, feine Linien und Farbflächen beizubehalten. Andere Modelle sind auf realistische Fotos, CGI, Gesichter oder Videoframes spezialisiert.

Zweck: Welches Problem soll das Modell lösen?

Upscaling-Modelle können verschiedene Aufgaben übernehmen. Einige sind für die allgemeine Skalierung konzipiert, während andere auf spezifische Verbesserungen abzielen, wie Kompressionsartefakte entfernen, Rauschen reduzieren, Unschärfe beheben oder Farben restaurieren.

Architektur: Auf welcher Technologie basiert das Modell?

Verschiedene Architekturen haben unterschiedliche Stärken und Einsatzbereiche. Beispielsweise sind ESRGAN und SwinIR weit verbreitet für allgemeines Upscaling. Die Wahl der Architektur beeinflusst die Qualität, Geschwindigkeit und den Ressourcenverbrauch des Modells.

Dateityp: In welchem Format liegt das Modell vor?

- .pth ist das Standardformat für PyTorch-Modelle.

- .safetensors ist eine sichere Alternative zu .pth; man sagt, sie sollen weniger wahrscheinlich von Schadsoftware befallen sein.

- ONNX (.onnx) ist ein plattformübergreifendes Modellformat, das mit verschiedenen Laufzeitumgebungen kompatibel ist.

In ComfyUI funktionieren sowohl .pth- als auch .safetensors-Modelle problemlos. ONNX habe ich bisher nicht ausprobiert.

Skalierung: Auf welchen Faktor soll das Bild vergrößert werden?

Üblich sind 2x, 4x oder 8x. Es geht auch höher, aber damit habe ich keine Erfahrung und würde wahrscheinlich eher mehrere kleinere Vergrößerungsschritte durchführen, anstatt einen einzigen 16x-Schritt.

Eingabetyp: Welche Art von Medien soll verarbeitet werden?

Die meisten Modelle sind für Bilder optimiert, aber es gibt auch Modelle, die für Videos entwickelt wurden.

Farbraum: In welchem Farbraum ist dein Bild dargestellt?

Manche Modelle sind auf Graustufenbilder (Grayscale) spezialisiert, während andere mit RGB oder RGBA arbeiten. In ComfyUI arbeitet man oft mit PNGs, und typische Farbräume für PNGs sind sRGB, RGB oder Grayscale.

Lizenz: Unter welchen Bedingungen darf das Modell genutzt werden?

Wenn du privat unterwegs bist, ist es weniger wichtig, aber sobald du den Upscaler kommerziell nutzen willst, musst du dich erkundigen, unter welcher Lizenz er veröffentlicht wurde.

Mein erster Schritt bei der Suche nach einem passenden Modell führt mich zu OpenModelDB. Falls ich dort nicht fündig werde, suche ich weiter auf GitHub und Hugging Face. Während der Recherche für diesen Artikel bin ich auf Philip Hofmanns GitHub-Seite gestoßen. Er trainiert regelmäßig Upscale-Modelle, ist auf GitHub aktiv, betreibt einen eigenen YouTube-Kanal, und alle Modelle, die ich von ihm gesehen habe, stehen unter der CC BY 4.0-Lizenz .

Eine Liste seiner neuesten Modelle findest du hier.

Er erfüllt viele Kriterien, die Vertrauen schaffen, sodass ich keine Bedenken habe, ein Modell von ihm zu nutzen. Beim ständigen Experimentieren und Testen verschiedener Modelle besteht immer das Risiko, sich schadhafte Software einzufangen – doch bei ihm habe ich diese Sorge nicht.

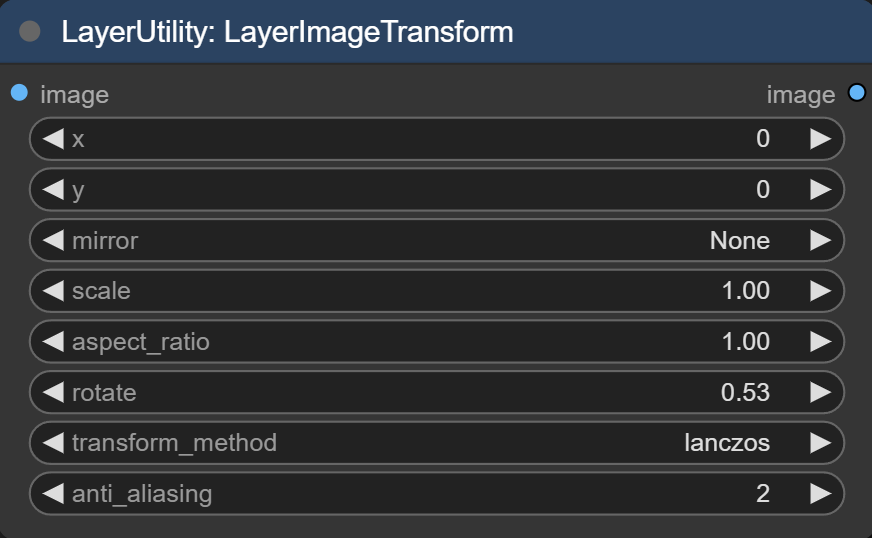

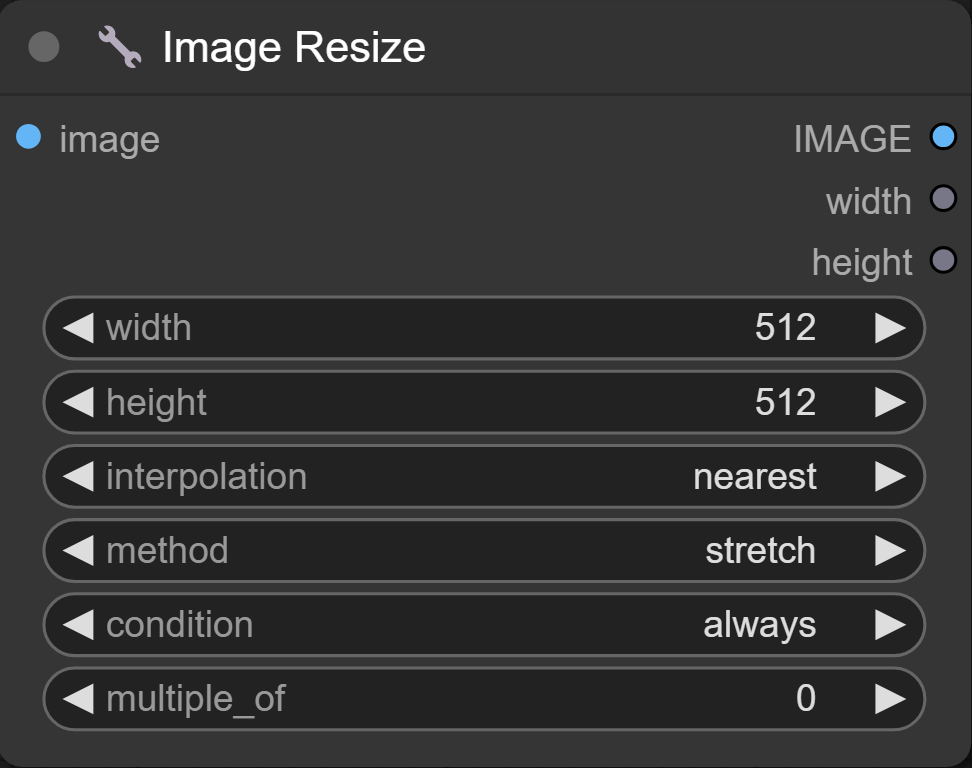

5 Traditionelle Upscaler

In ComfyUI findest du die traditionellen Upscaler in vielen Nodes, zum Beispiel in Image Resize von ComfyUI_essentials oder LayerImageTransform von ComfyUI_Layerstyle. Dabei werden üblicherweise Lanczos, bicubic, area, bilinear und nearest-exact als Optionen geboten. Diese Upscaler sind bereits in den Nodes integriert, sodass du keine zusätzlichen Modelle herunterladen musst.

Der große Unterschied zu KI-basierten Methoden besteht darin, dass traditionelle Upscaler keine zusätzlichen Details ergänzen, sondern neue Pixelwerte ausschließlich auf Basis benachbarter Pixel berechnen.

Noch einfacher gesagt basieren sie auf festen mathematischen Regeln(Interpolation) und liefern dadurch konsistente, vorhersagbare Resultate – ohne unerwartete Artefakte wie bei manchen KI-Modellen. Außerdem sind sie schneller und effizienter. Methoden wie Nearest Neighbor oder bilineare arbeiten sehr schnell und benötigen kaum Rechenleistung.

Geht es also um einfache, schnelle und ressourcenschonende Upscaling-Aufgaben, können traditionelle Methoden sinnvoll sein und sparen den Overhead/Zusatzaufwand eines KI-Modells.

Von den traditionellen Upscalern habe ich bisher immer Lanczos in meinen Workflows genutzt, weil es die besten Ergebnisse geliefert hat. Allerdings kommt es ganz auf deinen Anwendungsfall an. Wenn du zum Beispiel Pixel Art upscalen möchtest, macht es keinen Sinn, eine Methode zu nutzen, die weichere Übergänge erzeugt.

Ein häufiges Problem bei der Arbeit mit Stable Diffusion- oder Flux-Modellen ist, dass Bilder oft entweder zu groß oder zu klein für eine optimale Bearbeitung sind. Modelle wie SDXL liefern die besten Ergebnisse bei bestimmten Pixelgrößen und Seitenverhältnissen. Moderne Kameras und Smartphones erzeugen jedoch meist sehr große Bilder (z. B. 4000×4000 Pixel oder mehr). Wenn man solche Bilder in ComfyUI nutzen möchte, kann das schnell problematisch werden. Beim Inpainting einzelner kleiner Bildbereiche sind die ausgeschnittenen Bereiche hingegen häufig zu klein für eine effektive Bearbeitung.

Dieses Problem lässt sich durch den Einsatz traditioneller Upscaler lösen. In meinem Upscale-Workflow nutze ich Nodes wie „Resize Image“, um Bilder beliebiger Größe präzise auf eine optimale Auflösung für SD 1.5, SDXL oder Flux anzupassen.

Lade den Workflow einfach herunter und integriere ihn direkt in deine Projekte, um die optimale Bildgröße für bessere Ergebnisse zu erhalten.

6 Tiling

Tiling ist eine Methode, bei der ein Bild in mehrere kleine Abschnitte (Tiles) aufgeteilt wird, um diese einzeln zu bearbeiten.

Wenn ein Bild vergrößert wird, kann Tiling helfen, indem jeder Teilbereich (Tile) separat skaliert wird. Das entlastet den Computer, weil nicht das gesamte Bild auf einmal bearbeitet werden muss.

Hinweis:

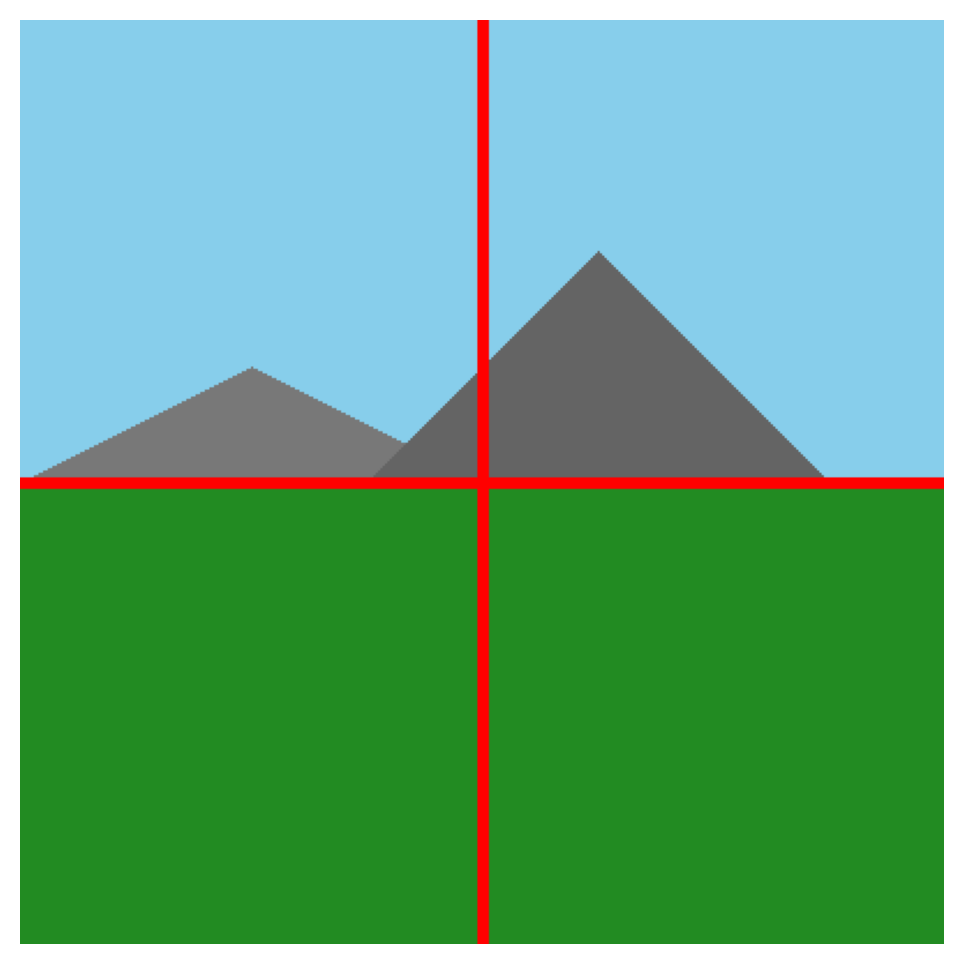

Wenn ein einheitlicher Prompt für alle Bildteile verwendet wird, können unerwünschte Details in Bereichen auftauchen, wo sie nicht vorgesehen sind. Hier ein Beispiel: Eine wunderschöne Grasfläche mit Bergen und Himmel, die in 4 unterschiedliche Abschnitte unterteilt wurde. Stell dir vor jeder Tile wird mit dem Prompt für das ganze Bild skaliert.

Tiling kann erheblich Speicherplatz sparen und die Bilddetails verbessern, doch ein einheitlicher Prompt für alle Tiles führt oft zu Inkonsistenzen – daher sollte das Prompting individuell auf die jeweiligen Tiles abgestimmt sein, um ein sinnvolles Gesamtbild zu bekommen.

Ich hoffe, der Artikel war hilfreich für dich! 😊